信息度量的方法有很多,这里用的是统计度量

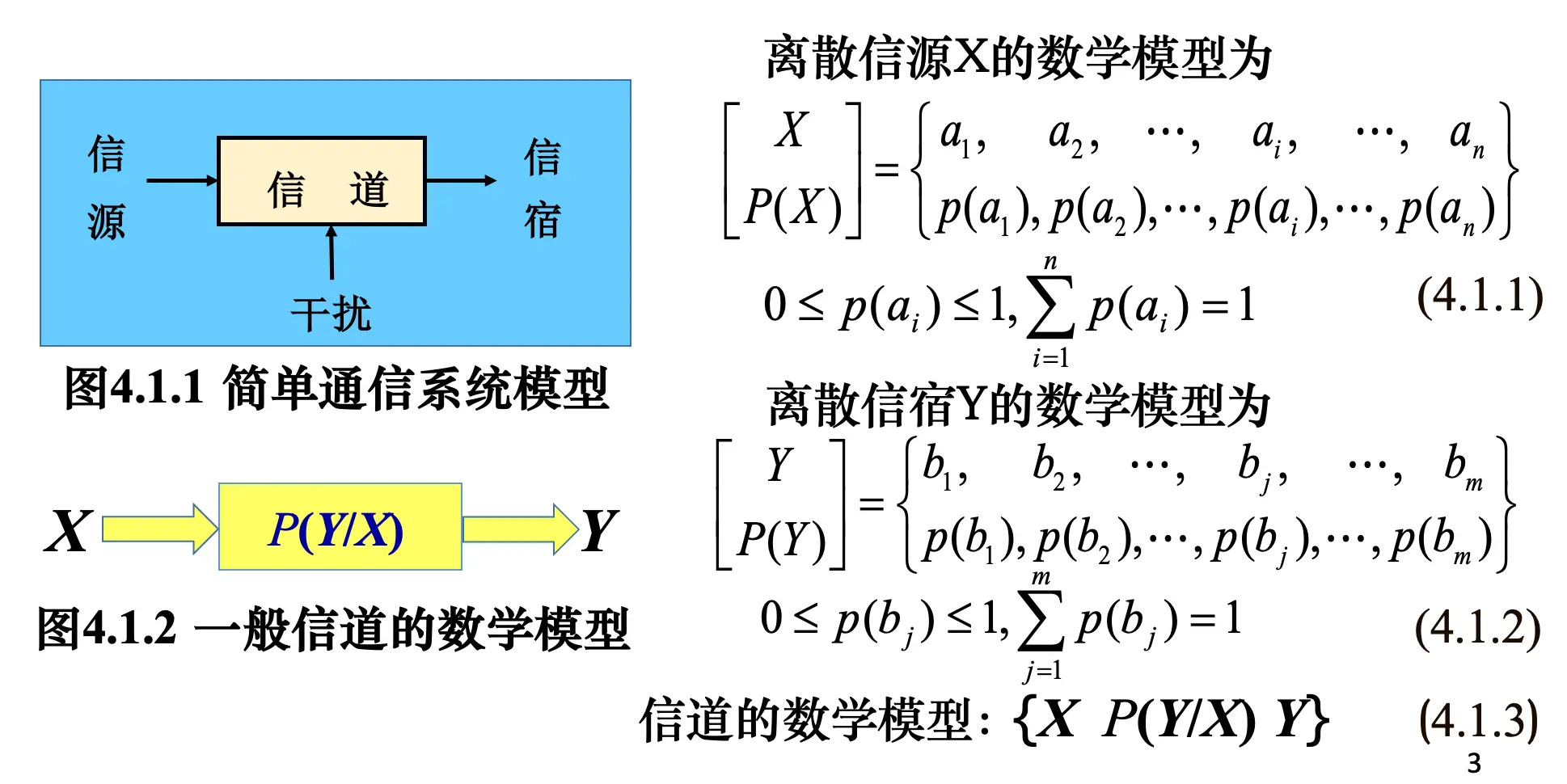

离散信源:信源输出的是一个个符号,符号的取值是可数的,取自一个有限集合

有简化符号:

这里的概率实际上就是一个分布,彼此之间不一样

单符号离散信源的数学模型

大写字母代表随机变量,a 是具体的某个符号

: 信道转移概率矩阵,维度为 。矩阵的第 行第 列元素 表示输入为 时,输出为 的概率。

指向原始笔记的链接注意这里不是直接右乘 X,而是要转置一下。之所以这样做,是为了方便直接定位到“i 行 j 列”

满足一系列归一化、正值的性质

自信息量极其性质

自信息量

一个随机事件发生某一个结果后可以得到的信息量

概率越小,信息量越大;概率越大,信息量越小;一个确定事件的信息量是 0

可以看作特定事件的“惊喜度”

单位:比特(bit 2)、奈特(nat e)、哈特(hart 10)

自信息量是一个随机变量的函数,可以推广到联合自信息量

当相互独立的时候,对数有一个比较好的性质:

自信息量的定义可通过公理化条件唯一确定。

自信息量的性质

指向原始笔记的链接

- 非负性:;

- 单调性: 越小, 越大;

- 可加性:。

联合自信息量

当 X 和 Y 相互独立的时候,有

指向原始笔记的链接我们在用对数衡量世界概率的时候,对于两个独立事件同时发生所带来的信息理解成它们各自带来的信息相加

条件自信息量

即

不确定度表示含有多少信息,信息量表示随机事件发生后能够得到多少信息

在已知 b 事件发生之后,如果 a 发生可以得到多少信息,这个信息量可以用 ab 同时发生得到的信息量减去 b 发生得到的信息量得到

指向原始笔记的链接表示 b 发生了,a 发生还能多带来的“惊喜度”。(可以假想两个几乎是因果的事件和同时买两种彩票)

信源熵及其性质

信源熵

信源熵

各个离散消息自信息量的数学期望,即信源的平均信息量。单位:比特/符号

指向原始笔记的链接

- 表示信源输出后,离散消息所提供的平均信息量

- 表示输出前,信源的平均不确定度。不确定度越高(越靠近等概率),熵越高。

- 反映了变量 X 的随机性

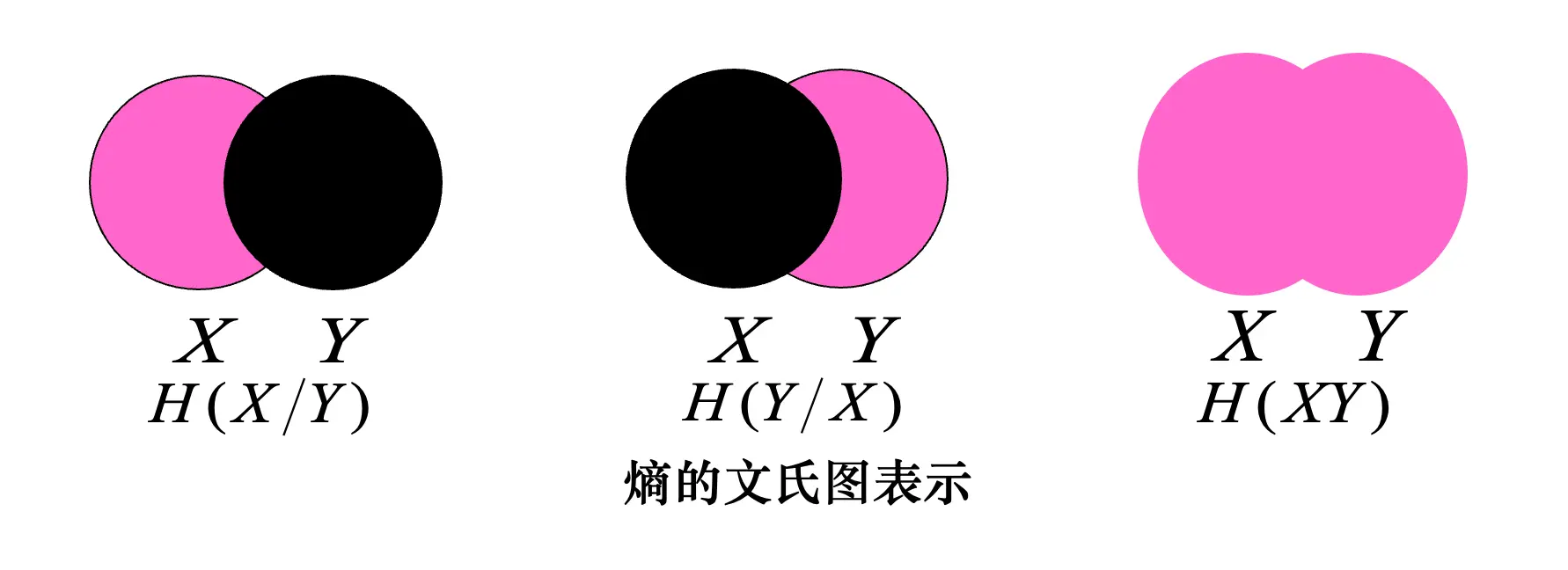

条件熵

这里是联合概率 ,因为这里是两个变量的期望(两个自由度),要算两次,一次条件,一次单独的变量,合在一起就是联合概率了

代表在知道 X 的前提下,随机变量 Y 的平均剩余的不确定性。是一个单一的数值,概括了 X 变化时,Y 不确定性的整体情况

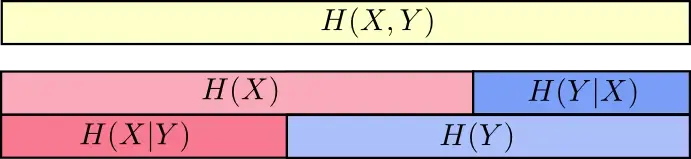

链式法则

指向原始笔记的链接

联合熵

指向原始笔记的链接

信息熵的性质

- 可加性:

- 非负性:熵结果非负

- 对称性:熵只和结构有关,不与具体的值有关(变量取值或者顺序)

- 最大离散熵定理:包含 n 种不同的离散信息,最大的信源熵是 ,证明:

令 ,因为

等式取等当且仅当 ,所以是等概率时最大

- 扩展性: 当一个事件概率很小的时候,它的信息量很大,但是对整个信息熵的影响很小。

- 确定性:当有一个是 1 的时候(确知信源),最后的熵的结果为 0

- 极值性:对任意两个消息数相同的信源,有:

对其他信源的自信息量与自身分布求期望,结果要大于自身的熵。这个可以推出:

即已知 Y 的信息会导致 X 的不确定度下降

指向原始笔记的链接

- 上凸性:熵是一个严格上凸函数: